Wolfgang Maass

Institut für Grundlagen der Informationsverarbeitung

Technische Universität Graz

email: maass@igi.tu-graz.ac.at

Zahlreiche Mythen vom Mittelalter über Goethes Faust bis zur Figur des Dr. Frankenstein beschäftigen sich mit der Vision künstliche intelligente Wesen im Forschungslabor zu erzeugen. Neue Entwicklungen in der Technik haben uns in den letzten Jahrzehnten der Möglichkeit näher gebracht, diese Vision zu realisieren. Die genauen Gründe, weshalb wir trotz unzähliger optimistischer Ankündigungen immer noch sehr weit davon entfernt sind1, ergeben eines der aufschlußreichsten Kapitel der modernen Wissenschaftsgeschichte. Erfreulich ist, daß mehreren Geistes- und Naturwissenschaften durch die jüngeren Fortschritte in der Mikroelektronik und Computertechnik neue Möglichkeiten erwachsen sind, ihre bisher überwiegend theoretisch betrachteten Modelle für Sehen, Hören, Erkennen, Lernen, Sprache und Denken experimentell zu überprüfen: indem man aufgrund eines solchen Modells ein künstliches System baut, das diese menschlichen Teilfunktionen ausüben soll. Dabei zeigt sich aber in der Regel, daß die traditionellen Modelle zu einfach waren und daß mehrere Jahrzehnte intensiver Entwicklungsarbeit notwendig sind, um den avisierten Teilfunktionen des Menschen wirklich näher zu kommen.

Auch bei der Entwicklung von Robotern ist in den 90'er Jahren eine gewisse Bescheidenheit eingekehrt. Anstatt einen künstlichen Übermenschen bauen zu wollen, ist man sich nunmehr bewußt geworden, daß unsere Kenntnisse nicht einmal ausreichen, um Roboter mit der Leistungsfähigkeit eines Insekts oder gar einer Maus zu erzeugen.2 Ein Grund ist der, daß selbst vermeintlich primitive Lebewesen eine Fähigkeit besitzen, die sie weit über unsere gegenwärtige Generation von Maschinen heraushebt: sie können lernen. Genauer gesagt, sie können unter Ausnutzung ihrer Sinneseindrücke und ihrer Erfahrung auf neue Anforderungen oder Änderungen in ihrer Umwelt in sinnvoller Weise reagieren. In den Universitäten und Forschungslabors arbeitet man gegenwärtig an der Entwicklung einer neuen Generation von Maschinen, die ebenfalls aus ihren "Sinneseindrücken" und "Erfahrungen" lernen können.3

Wir möchten die Möglichkeit, daß

Maschinen lernen können, durch unsere Installation in der

Landesausstellung

unmittelbar erfahrbar machen. Die vorgeführten Kleinroboter bilden

die Vorhut einer neuen Generation von lernfähigen Maschinen,

die

im Laufe des 21. Jahrhunderts alle Aspekte unserer Zivilisation

nachhaltig

verändern werden. Die in dieser Installation ausgestellten Roboter

wurden von Studierenden der Technischen Universität Graz im Rahmen

des im Frühjahr 1999 ausgeschriebenen Wettbewerbs "Robotik 2000"

mit

relativ geringen finanziellen Mitteln innerhalb von 9 Monaten entworfen

und gebaut. Die Wettbewerbsbedingungen sowie die Entstehungsgeschichten

der einzelnen Roboter können auf der Homepage

für diesen Wettbewerb nachgelesen werden. Unser wesentliches Ziel

bei der Konzeption des betreffenden track 2 dieses Wettbewerbs war, das

Lernen von Maschinen auf einer für eine Ausstellung angemessenen

Zeitskala

zu demonstrieren. Es sollte gezeigt werden, daß eine Maschine

innerhalb

von wenigen Minuten lernen kann, eine Aufgabe zu lösen, die so

anspruchsvoll

ist, daß sie ohne Lernen nicht bewältigt werden kann. Ein

derart

schnelles maschinelles Lernen stellt für die Wissenschaft eine

beträchtliche

Herausforderung dar, weil die üblichen in der Robotik angewandten

Methoden des maschinellen Lernens entweder nur relativ einfache

Aufgaben

bewältigen, die im Prinzip auch ohne maschinelles Lernen

lösbar

wären, oder aber eine sehr viel längere Lernperiode von

vielen

Stunden, Tagen oder gar Wochen erfordern.4

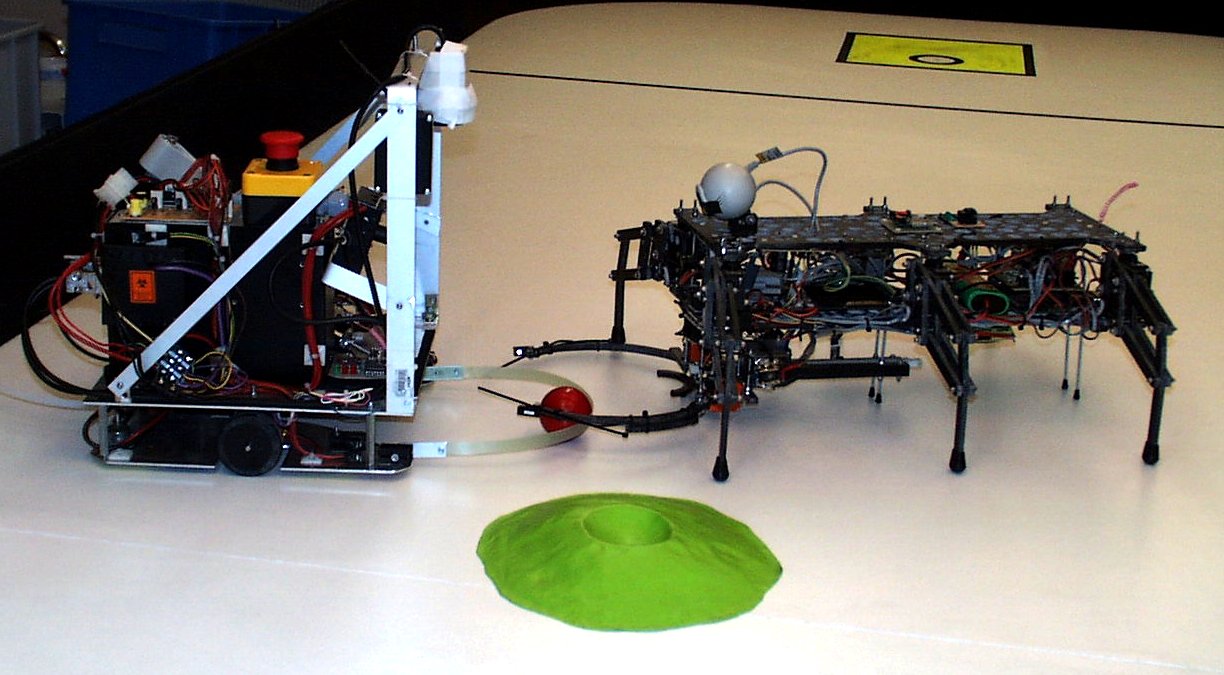

Die Roboter in dieser Installation lernen, durch gezieltes Probieren eine Geschicklichkeitsaufgabe zu bewältigen. Die Geschicklichkeitsaufgabe besteht darin, daß eine Kugel vom linken Fünftel der Spielfläche (siehe Abb. 1) in der genau richtigen Richtung a und mit der genau richtigen Geschwindigkeit v so "abzuschießen" ist, daß sie in einer kleinen Mulde oben auf einem im rechten Teil der Spielfläche plazierten Hügel zu liegen kommt. Wenn es sich hier jedesmal um denselben Hügel handeln würde, der sich jedesmal an derselben Stelle befindet, so könnte man die richtigen Werte a und v als fixe Werte im Programm des Roboters vorgeben. Das ist hier aber nicht möglich, weil sich der Roboter ständig auf eine neue Variante dieser Geschicklichkeitsaufgabe einstellen muß. Wir benutzen mehrere verschieden geformte Hügel, die jeweils an einer anderen Stelle im ca. 4 x 2 m großen Areal rechts von der schwarzen Trennlinie positioniert werden. Wir haben diese Hügel bewußt in unregelmäßiger Weise mit der Hand geformt, sodaß bei einer leichten Drehung des Hügels eine anders strukturierte Hügelflanke dem linken Teil der Spielfläche zugewendet ist, von wo der Roboter den Ball "abschießen" muß.5 Zusätzlich verwenden wir während der Ausstellung von Zuschauern veränderte Hügel, denen die Roboter niemals vorher begegnet sind. Da die Roboter also jedesmal eine neue Geschicklichkeitsaufgabe lösen müssen, zu der in ihrem Programm keine richtigen Werte von a und v für den Abschuß der Kugel vorgesehen werden konnten, müssen sie durch gezieltes Probieren lernen, diese Aufgabe zu lösen. Wesentlich hierfür ist die Fähigkeit, aus der Verarbeitung ihrer "Sinneseindrücke", also ihrer Videoaufnahmen von den vorhergehenden Fehlversuchen, die richtigen Schlüsse zu ziehen. Nach einem Fehlversuch muß der Roboter die Kugel vollkommen selbständig suchen und zurückholen.

Wir haben in dieser Installation zusätzlich versucht, bei der Kommunikation zwischen Mensch und Maschine neue Wege zu gehen. Während üblicherweise Maschinen in der Rolle einer vom Menschen gesteuerten Marionette verharren müssen, sind die Roboter in dieser Installation vollkommen autonom. Ihre "Intelligenz" erhalten sie durch Mini-Computer, die sie ständig mit sich herumtragen, und aus ihren mitgeführten Akkus mit Strom versorgen. Sie können von außen, also insbesondere vom Menschen, nur über zwei einfache mechanische Schalter beeinflußt werden.6 Sehr viel mehr Information fließt von den Robotern zum Menschen. Zum einen können die Zuschauer "mit dem Auge des Roboters sehen": das von der Mini-Videokamera auf dem Roboter aufgenommene Bild, das den wichtigsten "Sinneseindruck" für den Roboter darstellt, wird drahtlos vom Roboter zu einer Empfangsstation übertragen und dem Zuschauer in Echtzeit auf der rechten Projektionsfläche gezeigt. Gleichzeitig sendet der Roboter auf die linke Projektionsfläche die gegenwärtigen Meßwerte seiner anderen Sensoren (Infrarotsensoren, Ultraschallsensoren, Lichtschranken), die von Roboter zu Roboter variieren. Daher kann sich der Zuschauer jederzeit ein vollständiges Bild von den gegenwärtigen "Sinneseindrücken" des Roboters machen und sich somit in die Informationsverarbeitungsaufgabe des Roboters hineinversetzen ("wie würde ich auf diese Sinneseindrücke reagieren, wenn ich der Roboter wäre?"). Damit der Zuschauer erfährt, welche Schlüsse der Roboter selbst aus seinen Wahrnehmungen zieht, insbesondere wie er daraus lernt, senden die Roboter zusätzlich Kommentare, die ebenfalls auf der linken Projektionsfläche angezeigt werden.

Die Konstruktion intelligenter Maschinen erfordert die Integration von Methoden aus vielfältigen Bereichen der Wissenschaft und Technik. Das wird zum Beispiel ersichtlich aus der neuen Robotik-homepage der Technischen Universitaet Graz die anläßlich dieses Wettbewerbs eingerichtet wurde um unseren Studierenden den Zugang zu diesem komplexen Fach zu erleichtern. Es ist beachtlich, daß es den studentischen Teilnehmern am Wettbewerb Robotik 2000 gelungen ist, diese Vielzahl von Methoden und wissenschaftlichen Erkenntnissen in ihren Köpfen zu vereinigen.7 Die einzelnen von den studentischen Teams konstruierten Roboter werden im Anhang vorgestellt. Der Sieger des Wettbewerbs ist der von Gerald Steinbauer und Roland Koholka (Team 3) gebaute Roboter "Oskar".

Die von den studentischen Teams benutzten Methoden des maschinellen Lernens zeigen, daß nicht nur beim Menschen sondern auch beim Roboter sinnliche Wahrnehmung und Lernen Hand in Hand gehen. Die Roboter analysieren bei Fehlversuchen die über ihre Video-Kamera aufgenommene Bahn der Kugel am Hügel und schließen daraus, was sie beim nächsten Versuch anders machen sollten. Solche Rückschlüsse sind nicht einfach, weil zum einen der Zufall eine große Rolle dabei spielt, wie die Kugel über die Platte und den unregelmäßig geformten Hügel rollt, und zum anderen die räumliche und zeitliche Auflösung der in track 2 des Wettbewerbs verwendeten preiswerten Videokameras nicht sehr hoch ist. Einige der Roboter verwenden zusätzlich ein künstliches neuronales Netz, um anhand von früheren erfolgreichen Versuchen bei anderen Hügeln geeignete Abschußwerte für den ersten Versuch bei einem neuen Hügel vorherzusagen. Alle Software für Bildverarbeitung und maschinelles Lernen wurde - wie auch die Software zur Motorsteuerung - von den studentischen Teams selbst entworfen und geschrieben.

Ganz besonders herzlich danken möchte ich den Kollegen und Mitarbeitern an der Technischen Universität Graz, die die Studierenden bei ihrer Wettbewerbsarbeit beraten haben: Prof. Dr. Axel Pinz (Institut für Elektrische Meßtechnik und Meßsignalverarbeitung) beim maschinellen Sehen, Prof. Dr. Reinhard Braunstingl (Institut für Allgemeine Mechanik) bei der Steuerung der Roboter, Prof. Dr. Gerhard Wießpeiner (Institut für Elektro- und Biomedizinische Technik, Abteilung für Medizinische Elektronik) bei der Stromversorgung der Roboter, sowie Dr. Thomas Natschläger, Oliver Friedl und Dipl.-Ing. Harald Burgsteiner von meinem Institut bei vielfältigen Fragen der Roboter-Hardware und Software. Ich möchte zusätzlich Oliver Friedl, Dr. Thomas Natschläger und Prof. Dr. Axel Pinz für ihre fachliche Beratung bei der Konzeption von diesem track 2 des Robotik-Wettbewerbs danken. Schließlich danke ich den Kollegen Prof. Dr. Nicolaos Dourdoumas (Institut für Regelungstechnik), Prof. Dr. Adolf Frank (Institut für Fertigungstechnik) und Prof. Dr. Andres Kecskemethy (Institut für Mechanik und Getriebelehre) für ihre freundliche Unterstützung bei der Initiierung des Wettbewerbs sowie der Basisgruppe Telematik für die freundliche Überlassung eines Raumes für diesen Wettbewerb. Last not least danke ich Prof. Richard Kriesche für seine unermüdliche Inspiration und Unterstützung sowie dem Land Steiermark und der Landesausstellung gr2000az für die Finanzierung dieses Robotik-Wettbewerbes.

Die für diesen Wettbewerb entwickelten

Roboter

wurden bereits mit dem Robotik Award 2000 der Firma Knapp Logistik

Automation GmbH ausgezeichnet. Ich würde mich sehr freuen, wenn

die in dieser Installation gezeigte Vorhut einer neuen Generation von

lernfähigen Maschinen eine Reihe von Firmen und

Forschungsinstitute in der Steiermark motivieren würde, diese

Zukunftschancen verstärkt in ihre Entwicklungsarbeit

miteinzubeziehen.

1Man muß hinzufügen,

daß im

Gegensatz zu dem Bild, das sich aus der Fachliteratur ergibt,

zahlreiche Pressemeldungen - selbst in seriösen

österreichischen Zeitungen - ständig den Eindruck

vermitteln, daß soeben wichtige Durchbrüche erzielt wurden

oder unmittelbar bevorstehen. Bei genauerer Betrachtung sieht man,

daß dies in der Regel ohne kritische Überprüfung

abgedruckte "Public Relations" Mitteilungen einzelner Firmen oder

Institute sind. Dadurch erhält die Öffentlichkeit ein

optimistischeres Bild vom state-of-the-art als der Fachwissenschaftler

selbst.

2Siehe zum Beispiel

das Buch "Cambrian Intelligence: The Early History of the New AI" von

Rodney Brooks (MIT Press, Cambridge, 1999), sowie meinen

Übersichtsartikel "Das menschliche Gehirn: nur ein Rechner?" (https://igi-web.tugraz.at/people/maass/gehirn/index.html)

und

die dort angeführte Literatur.

3Siehe zum Beispiel http://www.ics.uci.edu/~mlearn/MLOther.html,

den

Cluster "Maschinelle Intelligenz" für Studierende der

Technischen Universität Graz:

http://www.igi.tugraz.at/cluster/clusters.html, sowie die Arbeit der

Forschungsgruppe von Prof. Dr. Axel Pinz (http://www.emt.tu-graz.ac.at/~pinz)

an

unserer Universität.

4Siehe die auf http://www.igi.tu-graz.ac.at/STIB/WS98/

diskutierten Methoden.

5Die genaue Regel beim Wettbewerb

besagt, daß der Ball anfangs in dem gelb markierten Quadrat im

linken Areal positioniert ist. Der Roboter darf die Kugel von einem

beliebigen Punkt im linken Areal (d.h. links von der schwarzen

Trennlinie) abschießen.

6Die Roboter haben alle einen roten

Ein-/Ausschalter, sowie einen grünen Schalter, dessen

Betätigung dem Roboter signalisiert, daß er nun beginnen

soll, die Kugel vom Startpunkt auf den Hügel zu

befördern.

7Viele

Teilnehmer sind Studierende des Studienganges Telematik an der

Technischen Universität Graz (siehe http://www.tu-graz.ac.at/studium/

und https://htugraz.at/)

,

der diese Vielseitigkeit in erfreulicher Weise fördert. Der

Cluster Maschinelle Intelligenz (http://www.igi.tugraz.at/cluster/clusters.html)

ist

einer von vielen möglichen Schwerpunkten in diesem

Studium.

Anhang: Vorstellung der Teilnehmer bei Track 2 des Wettbewerbs Robotik 2000 und ihre Projekte

Robotik Team 1

Mitglieder unseres Teams :

Erhard Hackl Studienrichtung Elektrotechnik-Biomedizin, wohnhaft in

St.Georgen (Oberösterreich)

Manfred Rittler Studienrichtung Telematik, wohnhaft in Trins (Tirol)

Andreas Grießer Studienrichtung Telematik, wohnhaft in Dornbirn

(Vorarlberg)

Fahreinheit

:

Fahreinheit

:

Zur Fortbewegung unseres Roboters 'Homer J.' dient ein einzelnes hinten

angebrachtes, lenkbares Antriebsrad. Ein 12V-Gleichstrommotor mit

2stufigem

Planetengetriebe und einer Nennleistung von 20W sorgt für eine

Maximalgeschwindigkeit

von ca. 1,5m/s. Gelenkt wird mit Hilfe eines Hochleistungs-Servos, der

einen maximalen Lenkwinkel von ca. 180 Grad erreicht.

Kugel-Abschußmechanismus :

Um möglichst wenig Energie beim Beschleunigen

der Kugel zu verlieren verwenden wir eine Art Rampe, auf der die Kugel

auf eine bestimmte Höhe gebracht und dann losgelassen wird. Die

genaue

Positionierung entlang der Rampe erledigt ein Schrittmotor, der eine

Spindel

antreibt und einen auf einer Laufmutter befindlichen Schlitten bewegt.

Um die Kugel einzufangen ist auf dem Rampenschlitten ein Greifer

montiert,

der sich nicht nur öffnen und schließen sondern auch nach

oben

unten bewegen lässt. Lichtschranken auf dem Greifer sorgen

für

ein automatisches Einfangen der Kugel. Die Rampe selbst lässt sich

per Servo vorne um ca. 1cm nach links und rechts drehen bzw. beim

Fahren

anheben und beim Abschuß auf den Boden absenken.

Elektronik

:

Elektronik

:

Die Elektronik besteht hauptsächlich aus 2

Teilen : einem Hauptrechner (Cyrix 233MHz MMX-CPU), sowie einem

Microcontroller-Board,

das die komplette Sensorik sowie die Ansteuerung der Hardware

übernimmt.

Auf dieser Controllerplatine befinden sich 2

unabhängige

Netzteile, die Ansteuerung für 2 Schrittmoren, 5 Servos, 1

DC-Motor

und 4 Ultraschall-Sensoren. Auch die Auswertung der Sensorsignale,

Ultraschall,

8 Lichtschranken, 3 Helligkeitssensoren und Batteriespannungsmessung,

ist

hier untergebracht.

Folgende Sensorsignale werden ausgewertet :

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Um die Bilder der CCD-Farbkamera zu digitalisieren benutzen wir einen PC104-Framegrabber, der direkt über dem Hauptrechner montiert ist.

Software :

Als Betriebssystem kommt SuSE-Linux 6.1 (Kernel

2.2.5) auf einer als read-only gemounteten 48MB Flashdisk zum Einsatz.

Die Software des Hauptrechners ist größtenteils in C/C++

geschrieben,

teilweise aber auch in Assembler. Das endgültige Programm ist in 6

'parallele' Prozesse aufgeteilt, die miteinander kommunizieren und

Daten

austauschen können.

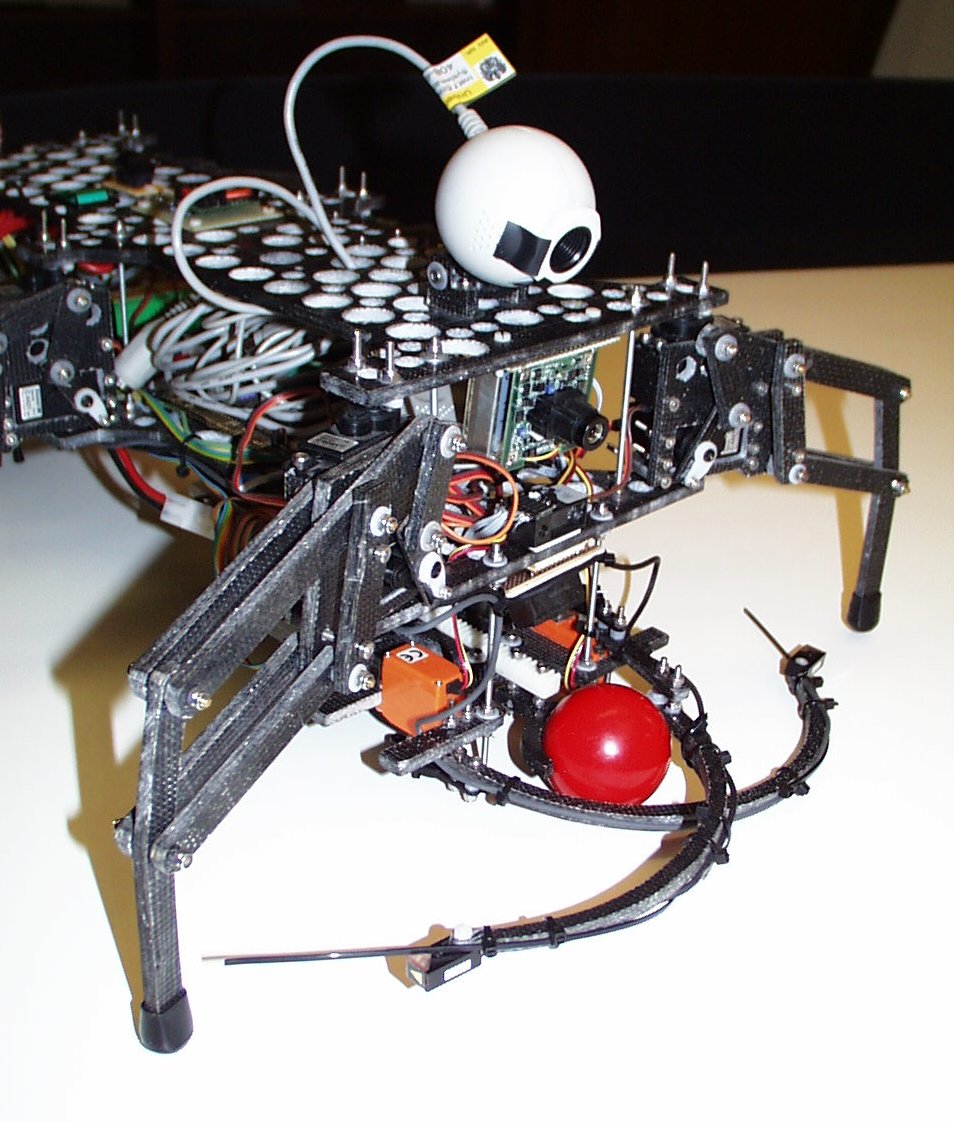

Roboter AntOnOff und Team 2

Um die Aufgabenstellung beim Robotikwettbewerb zu erfüllen, haben

wir uns für einen sechsbeinigen Roboter entschieden, da dieses

Konzept

zusätzlich eine besondere Herausforderung in bezug auf die

Mechanik

und deren Steuerung darstellte. Für die Realisierung haben wir uns

an den in der Natur vorkommenden sechsbeinigen Lebewesen orientiert,

die

ja zum Teil recht passabel funktionieren (wegen der nun doch sehr

langen

Zeit der Evolution). Als angenehmes Beispiel betrachteten wir den

Bewegungsapparat

von Ameisen, im speziellen der Formica rufa (gemeinen Waldameisen) aus

der Familie der Formicidae. Wir haben also diese Gattung mit einer

Kamera

aufgezeichnet und AntOnOff?s Gehalgorithmus dementsprechend diesen

lieben

Tieren angepaßt (Anm. für unsere Naturfreunde: die

Versuchstiere

wurden, wie unserer Roboter später auch, wieder in der Natur

ausgesetzt).

Um die Aufgabenstellung beim Robotikwettbewerb zu erfüllen, haben

wir uns für einen sechsbeinigen Roboter entschieden, da dieses

Konzept

zusätzlich eine besondere Herausforderung in bezug auf die

Mechanik

und deren Steuerung darstellte. Für die Realisierung haben wir uns

an den in der Natur vorkommenden sechsbeinigen Lebewesen orientiert,

die

ja zum Teil recht passabel funktionieren (wegen der nun doch sehr

langen

Zeit der Evolution). Als angenehmes Beispiel betrachteten wir den

Bewegungsapparat

von Ameisen, im speziellen der Formica rufa (gemeinen Waldameisen) aus

der Familie der Formicidae. Wir haben also diese Gattung mit einer

Kamera

aufgezeichnet und AntOnOff?s Gehalgorithmus dementsprechend diesen

lieben

Tieren angepaßt (Anm. für unsere Naturfreunde: die

Versuchstiere

wurden, wie unserer Roboter später auch, wieder in der Natur

ausgesetzt).

Als Sinnesorgane dienen unsrem Roboter AntOnOff eine digitale Farbkamera, ein Hand voll Infrarot-Abstandssensoren und ein Kompaß, um die Orientierung nicht zu verlieren. Das Gehirn besteht bei AntOnOff aus einem Pentium Rechner und einem Microcontroller, die sich die Lösung der gestellten Aufgabe wie folgt aufteilen: Der schnellere PC übernimmt die rechenaufwendige Bildverarbeitung und den adaptiven Lernalgorithmus, wobei der kleinere Bruder den gesamten Gehapparat sowie die Sensoren und Aktoren kontrolliert. Als Aktoren wurden eine Abschußvorrichtung, die den Ball auf den Hügel befördern soll, und eine Fangvorrichtung zum Holen des Balles benötigt. Die Fangvorrichtung wurde wiederum den Kauwerkzeugen der Ameisen nachempfunden. Um einen autonomen Betrieb für eine Zeit von ca. 45 Minuten zu gewährleisten, wurden 2 Akkus mit fortschrittlicher NiMh-Technologie verwendet.

Schlußendlich stellte sich die Aufgabenstellung als wesentlich komplexer dar, als wir es zu Beginn des Bewerbs angenommen hatten, denn bei AntOnOff mußten wir sehr auf das Gewicht achten (Diät?), denn Übergewicht fordert mehr Stromverbrauch und somit einen schwereren Akku und damit schließt sich der Kreis wieder. Dieses Problem konnten wir nur durch Einsatz von ultraleichten Materialien und hochtechnologischen Komponenten (low-power-components) in den Griff bekommen.

Teammitglieder:

AntOnOff (Ameise, bei der man nie weiß, ob

sie ein- oder ausgeschaltet ist)

Franz Stephan Helmli (techn. Mathematik)

Josef Zipper (Elektrotechnik)

Der Wettbewerbssieger:

Robotik Team 3

Beim Design des Roboters Oskar durch Gerald Steinbauer (Telematik) und DI Roland Koholka (Telematik) wurde darauf Wert gelegt, daß es möglichst wenig bewegliche Teile gibt und die Funktionalität einfach vom Zuschauer zu durchschauen ist.

Angetrieben wird Oskar durch zwei Schrittmotoren,

auf die Räder aufgesteckt sind . Sie erlauben zwar nur eine

Geschwindigkeit

von ca. 10m/min, dafür kann sich Oskar sehr exakt bewegen. Durch

Drehen

der Motoren mit verschiedenen Geschwindigkeiten und Richtungen kann

Oskar

sich am Stand drehen oder Kurven fahren. Die Abschußposition kann

mit einer Genauigkeit von 1mm und einem Winkelfehler 0.2° immer

wieder

eingenommen werden, was für ein schnelles Lösen der Aufgabe

essentiell

ist.

Die Abschußvorrichtung besteht aus einem Hammer und einem Schrittmotor. Die in der Bodenplatte ausgenommene Führung ist so konstruiert, daß der Ball immer an einer definierten Position liegt. Beim Abschuß des Balles wird der Hammer gehoben, und durch Abschalten des Stroms losgelassen. Der Hammer übernimmt also die Funktion eines Golfschlägers.

Beim Einsammeln des Balles benutzt Oskar sein flexibles Lasso, um den Ball in seiner Nähe zu fixieren. Anschließend befördert er den Ball mit einem "Hüftschwung" in sein Inneres, wo er mit einer Klappe an die Abschußposition befördert wird.

Durch zwei Kameras nimmt Oskar seine Umwelt wahr. Eine Kamera ist nach vorne gerichtet, die dient zum Aufnehmen der Bahnkurve beim Schießen, zum Erfassen des Hügels, sowie zur Suche des Balles beim Einsammeln. Ihr Bild wird auf der rechten Projektionsfläche gezeigt. Die zweite Kamera ist von oben direkt auf den Bereich vor dem Roboter gerichtet. Sie dient zum Erkennen von Hindernissen und zur genauen Positionierung im Startfeld.

Beim ersten Schuß versucht Oskar mittels

einem

eingebauten künstlichen neuronalen Netzwerk aus seiner Erfahrung

aus

früheren Treffern eine möglichst gute Vorhersage für den

Winkel und die Geschwindigkeit zu finden. Aus der Bewegung des Balles

am

Hügel leitet Oskar erfolgversprechende Werte für den

nächsten

Versuch ab. Diese Adaption seines Verhaltens setzt Oskar solange fort

bis

der Ball in der Mulde liegen bleibt.

Sisyphus 2000

Als

Basis unseres Roboters Sisyphus 2000 dienen handelsübliche

Modellbausätze

für Elektroautos. Das Vehikel verfügt über zwei Achsen,

die über je einen Gleichstrommotor angetrieben werden. Alle vier

Räder

können einzeln gelenkt werden. Die low-level Steuerung

übernehmen

ein Servocontroller und zwei weitere Mikrocontroller, die über

serielle

Schnittstellen mit dem Zentralrechner verbunden sind. Der Hauptrechner

ist ein Single-Board Industrie-PC der Pentium-Klasse mit geringer

Leistungsaufnahme.

Die Energieversorgung geschieht aus NC-Akkupacks (900g Gewicht und

60Wh)

und einem effizienten Schaltregler. Die verbrauchte Energie und

wichtige

Systemspannungen werden kontinuierlich erfaßt. Die Ansteuerung

der

Motoren erfolgt über einen elektronischen Fahrtenregler, der beim

Bremsen die kinetische Energie des Roboters in die Akkus

zurückführt,

unsere geschätzte Einsatzdauer beträgt in etwa vier Stunden.

Als

Basis unseres Roboters Sisyphus 2000 dienen handelsübliche

Modellbausätze

für Elektroautos. Das Vehikel verfügt über zwei Achsen,

die über je einen Gleichstrommotor angetrieben werden. Alle vier

Räder

können einzeln gelenkt werden. Die low-level Steuerung

übernehmen

ein Servocontroller und zwei weitere Mikrocontroller, die über

serielle

Schnittstellen mit dem Zentralrechner verbunden sind. Der Hauptrechner

ist ein Single-Board Industrie-PC der Pentium-Klasse mit geringer

Leistungsaufnahme.

Die Energieversorgung geschieht aus NC-Akkupacks (900g Gewicht und

60Wh)

und einem effizienten Schaltregler. Die verbrauchte Energie und

wichtige

Systemspannungen werden kontinuierlich erfaßt. Die Ansteuerung

der

Motoren erfolgt über einen elektronischen Fahrtenregler, der beim

Bremsen die kinetische Energie des Roboters in die Akkus

zurückführt,

unsere geschätzte Einsatzdauer beträgt in etwa vier Stunden.

An

Sensoren sind Infrarot-Abstandssensoren, ein elektronischer

Kompaß,

ein Beschleunigungssensor sowie diverse Lichtschranken und eine

Farbkamera

vorhanden. Um die Kugel abzuschießen, wird sie in Eigenrotation

versetzt,

indem sie mit einem Servo gegen eine rotierende Walze gedrückt

wird;

nach Öffnen des Bügels beschleunigt die Kugel aus der

Abschußvorrichtung.

Die Rotationsgeschwindigkeit der Walze wird über einen

Präzisionsmotor

mit Impulsgeber exakt eingestellt.

An

Sensoren sind Infrarot-Abstandssensoren, ein elektronischer

Kompaß,

ein Beschleunigungssensor sowie diverse Lichtschranken und eine

Farbkamera

vorhanden. Um die Kugel abzuschießen, wird sie in Eigenrotation

versetzt,

indem sie mit einem Servo gegen eine rotierende Walze gedrückt

wird;

nach Öffnen des Bügels beschleunigt die Kugel aus der

Abschußvorrichtung.

Die Rotationsgeschwindigkeit der Walze wird über einen

Präzisionsmotor

mit Impulsgeber exakt eingestellt.

Unser Team besteht aus Thomas Jaksch und Arnulf

Heller,

wir sind Telematik-Studenten kurz vor Studienabschluß.